1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

49

50

51

52

53

54

55

56

57

58

59

60

61

62

63

64

65

66

67

68

69

70

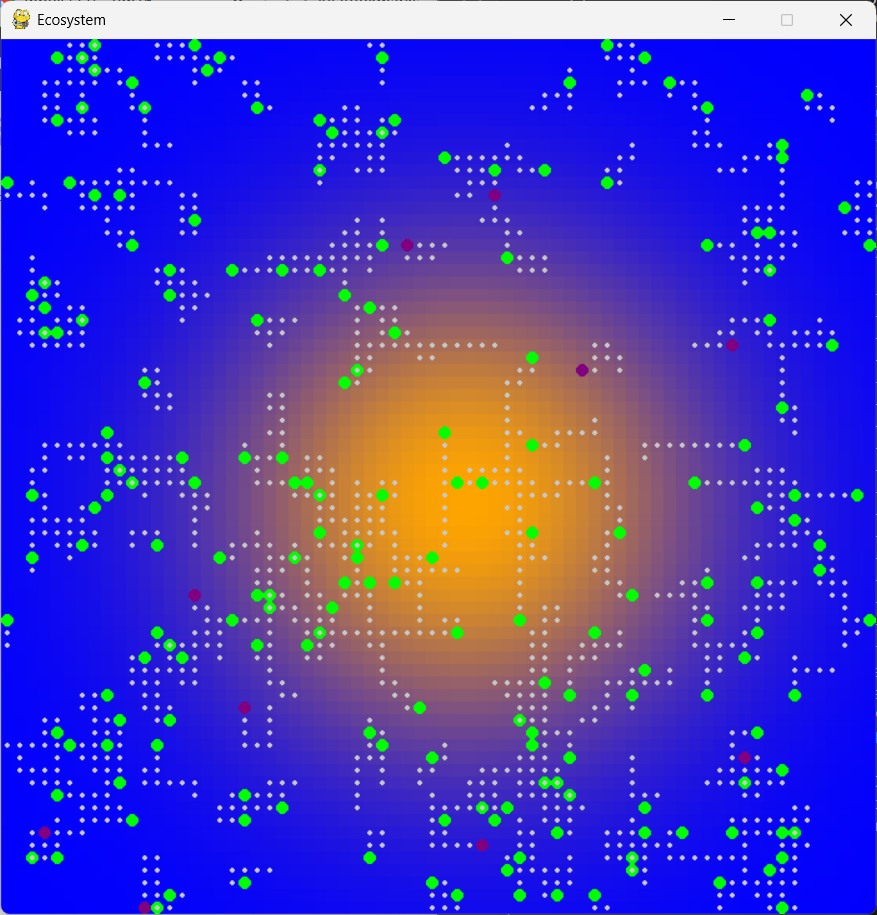

| pygame 2.6.1 (SDL 2.28.4, Python 3.11.0)

Hello from the pygame community. https://www.pygame.org/contribute.html

[Step 100] Plants: 209, Predators: 11

[Step 200] Plants: 223, Predators: 16

[Step 300] Plants: 251, Predators: 23

[Step 400] Plants: 227, Predators: 31

[Step 500] Plants: 185, Predators: 42

[Step 600] Plants: 155, Predators: 45

[Step 700] Plants: 92, Predators: 54

[Step 800] Plants: 73, Predators: 56

[Step 900] Plants: 48, Predators: 59

[Step 1000] Plants: 34, Predators: 57

[Step 1100] Plants: 29, Predators: 56

[Step 1200] Plants: 27, Predators: 50

[Step 1300] Plants: 27, Predators: 47

[Step 1400] Plants: 26, Predators: 35

[Step 1500] Plants: 24, Predators: 28

--- 过捕猎同步紧缩

[Step 1600] Plants: 19, Predators: 20

[Step 1700] Plants: 17, Predators: 14

[Step 1800] Plants: 15, Predators: 12

[Step 1900] Plants: 21, Predators: 8

[Step 2000] Plants: 26, Predators: 7

[Step 2100] Plants: 26, Predators: 3

[Step 2200] Plants: 25, Predators: 3

[Step 2300] Plants: 23, Predators: 2

--- 捕猎者濒临灭绝

[Step 2400] Plants: 21, Predators: 2

[Step 2500] Plants: 27, Predators: 2

[Step 2600] Plants: 54, Predators: 2

[Step 2700] Plants: 75, Predators: 2

[Step 2800] Plants: 77, Predators: 1

[Step 2900] Plants: 77, Predators: 1

[Step 3000] Plants: 70, Predators: 1

[Step 3100] Plants: 62, Predators: 1

[Step 3200] Plants: 65, Predators: 1

[Step 3300] Plants: 135, Predators: 1

[Step 3400] Plants: 226, Predators: 1

--- 植物复苏

[Step 3200] Plants: 65, Predators: 1

[Step 3300] Plants: 135, Predators: 1

[Step 3400] Plants: 226, Predators: 1

[Step 3300] Plants: 135, Predators: 1

[Step 3400] Plants: 226, Predators: 1

[Step 3400] Plants: 226, Predators: 1

[Step 3500] Plants: 259, Predators: 1

[Step 3600] Plants: 258, Predators: 2

[Step 3700] Plants: 243, Predators: 3

[Step 3500] Plants: 259, Predators: 1

[Step 3600] Plants: 258, Predators: 2

[Step 3500] Plants: 259, Predators: 1

[Step 3500] Plants: 259, Predators: 1

[Step 3600] Plants: 258, Predators: 2

[Step 3700] Plants: 243, Predators: 3

[Step 3800] Plants: 198, Predators: 3

[Step 3900] Plants: 180, Predators: 3

[Step 4000] Plants: 290, Predators: 3

[Step 4100] Plants: 391, Predators: 9

[Step 4200] Plants: 371, Predators: 23

[Step 4300] Plants: 244, Predators: 49

[Step 4400] Plants: 69, Predators: 94

--- 捕食者爆发

[Step 4500] Plants: 14, Predators: 103

[Step 4600] Plants: 5, Predators: 102

[Step 4700] Plants: 2, Predators: 95

[Step 4800] Plants: 0, Predators: 81

[Step 4900] Plants: 0, Predators: 53

[Step 5000] Plants: 0, Predators: 37

[Step 5100] Plants: 0, Predators: 21

--- 捕食者灭绝

|